Navtalk 200ms 级瞬时响应的实时数字人系统

1. 响应速度表现

在实际演示中,我们实现了音频首段处理的端到端延迟控制在 200 ms 以内 —— 从用户说完话,到 AI 完成处理、生成视频并在前端展示,仅耗时约 200 ms。目前这一响应速度,在所有实时数字人系统中处于非常领先的水平。

2. 未优化前的整体延迟情况

针对 MuseTalk 在 A100 GPU 环境下的实时性表现,我们进行了详细测试:

使用 0.5 秒实时音频输入进行测试时,处理时间超过了 0.5 秒,未能满足实时性要求。如下视频所示:

在将 FPS 调整为 18 后,实时音频输入的处理速度提升了约 0.2 秒,但仍需要进一步将 FPS 降低至 15 以下,才能达到实时性要求。

在增加 batch_size(批处理大小)后,处理时间反而增加,达到了芯片的处理极限。

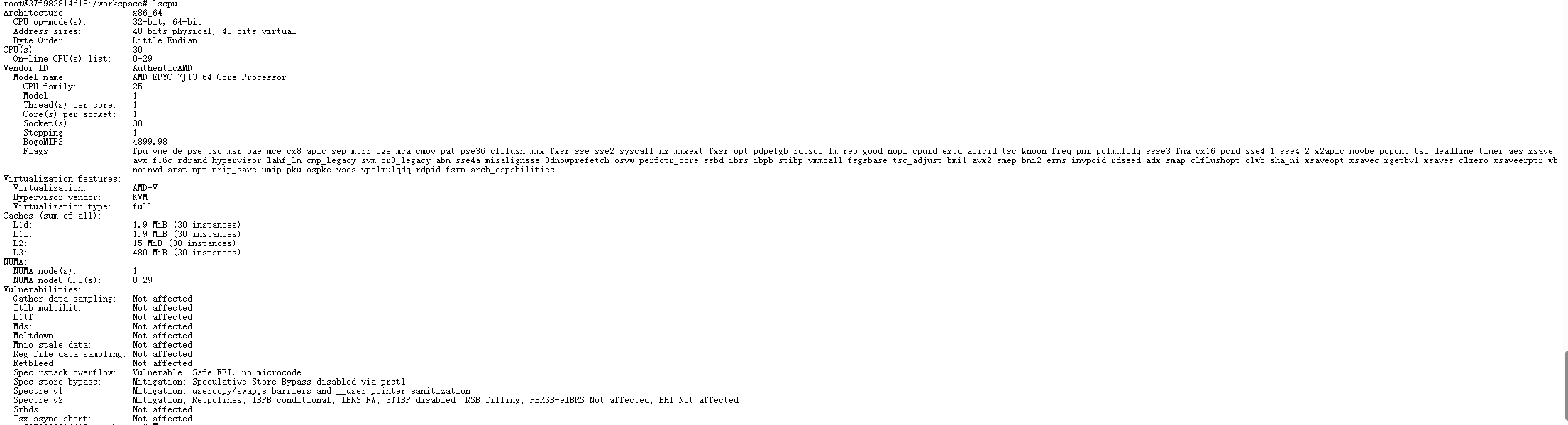

问题的根源在于 Lambda 默认租用的 A100 GPU 配备了 AMD 芯片,这使得它在图像处理等计算机视觉任务上的速度低于同类 Intel 芯片。具体来说,该系统使用的是 AMD EPYC 7J13 64-Core Processor,具有 30 核处理器,适合虚拟化和高并发任务,但在某些图像处理任务上,其性能不如 Intel 同类处理器。而不幸的是几乎所有GPU云提供商商,都是配备的AMD芯片。

一开始我也卡在这个问题上,性能优化进展受限。后来突然想到一个方向:是否可以借助 GPU 专门加速图像处理任务,从而突破当前的性能瓶颈?这个思路促成了接下来的一系列优化步骤。

3. GPU 加速图像处理的优化方案

3.1 优化思路

针对 AMD 芯片在图像处理上的性能瓶颈,核心思路是:将原本在 CPU 上执行的图像处理操作迁移到 GPU,充分利用 GPU 的并行计算能力。在 MuseTalk 的推理流程中,主要有以下几个图像处理步骤是在 CPU 上执行的:

1. VAE 解码后的数据转换:解码结果从 GPU tensor 转换为 numpy 数组,存在 GPU→CPU 的数据传输开销

2. 图像 Resize:使用 OpenCV 的 cv2.resize() 在 CPU 上进行图像缩放

3. 图像锐化:使用 OpenCV 和 NumPy 在 CPU 上执行 Unsharp Mask 锐化操作

4. 图像混合:使用 PIL 在 CPU 上进行图像合成和混合

这些操作虽然单个来看耗时不多,但在实时处理场景下,累积起来的延迟就相当可观了。更重要的是,它们完全可以利用 GPU 的并行计算能力来加速。

3.2 技术实现

3.2.1 创建 GPU 图像处理工具库

首先,我创建了一个专门的 GPU 图像处理工具库 musetalk/utils/gpu_image_processing.py,实现了以下核心函数:

gpu_resize():使用 PyTorch 的F.interpolate()实现 GPU 图像缩放gpu_gaussian_blur():使用 PyTorch 的F.conv2d()实现 GPU 高斯模糊gpu_unsharp_mask():基于 GPU 高斯模糊实现图像锐化gpu_image_blending():使用 tensor 操作实现 GPU 图像混合

这些函数都设计为支持多种输入格式([H, W, C]、[B, H, W, C]、[B, C, H, W]),并自动处理数据格式转换,保持了良好的易用性。基于processing.py文件修改,全部移植到GPU上加速处理。

3.2.2 优化 VAE 解码流程

修改了 musetalk/models/vae.py 中的 decode_latents() 方法,添加了 return_tensor 参数:

def decode_latents(self, latents, return_tensor=False):

# ... 解码逻辑 ...

if return_tensor:

# 返回 GPU tensor,避免 GPU→CPU 传输

image = image.permute(0, 2, 3, 1) # [B, H, W, C]

image = (image * 255.0)

image = image[..., [2, 1, 0]] # RGB to BGR

return image

else:

# 原有逻辑:返回 numpy 数组

image = image.detach().cpu().permute(0, 2, 3, 1).float().numpy()

# ...

return image这样,当 return_tensor=True 时,数据可以保持在 GPU 上,避免不必要的数据传输。

3.2.3 重构实时推理流程

在 scripts/realtime_inference.py 中,我重构了 process_frames() 方法,添加了 GPU 处理路径:

关键改动:

图像 Resize 优化

# 原来:CPU 处理

res_frame = cv2.resize(res_frame.astype(np.uint8), (x2 - x1, y2 - y1))

# 优化后:GPU 处理

res_frame_gpu = gpu_resize(res_frame, (y2 - y1, x2 - x1), mode='bilinear')图像锐化优化

在原始 MuseTalk 生成的视频中,我们注意到嘴部区域有时会显得略微模糊。为了提升视觉表现,我们引入了 图像锐化(sharpen) 作为后处理手段。

# 原来:CPU 处理(OpenCV + NumPy)

res_frame = apply_unsharp_mask(res_frame, amount=1.2, sigma=1.0, threshold=5.0)

# 优化后:GPU 处理

res_frame_gpu = gpu_unsharp_mask(res_frame_gpu, amount=1.2, sigma=1.0, threshold=5.0)图像混合优化

# 原来:CPU 处理(PIL)

combine_frame = get_image_blending(ori_frame, res_frame, bbox, mask, mask_crop_box)

# 优化后:GPU 处理

body_tensor = numpy_to_tensor_gpu(ori_frame, device)

face_tensor = res_frame_gpu # 已在 GPU 上

mask_tensor = numpy_to_tensor_gpu(mask, device)

combine_frame_tensor = gpu_image_blending(body_tensor, face_tensor, bbox, mask_tensor, mask_crop_box, device)

combine_frame = tensor_to_numpy_cpu(combine_frame_tensor)整个流程采用了自动降级机制:如果 GPU 处理失败,会自动降级到 CPU 处理,确保系统的稳定性。

3.3 性能提升表现

经过优化后,我们在 AMD EPYC 7J13 处理器 + A100 GPU 环境下进行了测试:

3.3.1 性能提升数据

3.3.2 整体效果

优化前:

0.5 秒音频输入需要超过 0.5 秒处理时间

无法满足实时性要求

需要将 FPS 降低至 15 以下才能勉强实时

优化后:

图像处理部分获得 3-5 倍速度提升

端到端延迟控制在 200 ms 以内

成功实现实时响应,用户体验显著提升

3.4 为什么 GPU 加速有效?

1. 并行计算优势:图像处理操作(如 resize、卷积、混合)本质上都是并行操作,GPU 拥有数千个核心,非常适合这类任务

2. 内存带宽:GPU 的显存带宽远高于 CPU 与主内存之间的带宽,避免了数据传输瓶颈

3. 计算精度灵活:GPU 支持 float32/half 等精度,可以根据需要灵活选择,在精度和速度之间取得平衡

4. musetalk的docker部署记录

4.1 构建和推送镜像

4.1.1 重新构建镜像

docker build -t xxx/musetalk:latest .4.1.2 推送新镜像到 Docker Hub

docker push xxx/musetalk:latest注意:推送前需要先登录 Docker Hub:

docker login4.2 删除和拉取镜像

4.2.1 停止并删除旧容器

sudo docker rm -f musetalk4.2.2 拉取最新镜像

sudo docker pull xxx/musetalk:latest4.3 运行容器

4.3.1 启动新容器

sudo docker run -d \

--name musetalk \

--gpus all \

--restart unless-stopped \

-p 2160:2160 \

gavana2/musetalk:latest参数说明:

- -d:后台运行(detached mode)

- --name musetalk:容器名称

- --gpus all:使用所有可用的 GPU(需要安装 nvidia-container-toolkit)

- --restart unless-stopped:自动重启策略(除非手动停止)

- -p 2160:2160:端口映射(主机端口:容器端口)

注意:首次运行时会自动从 HuggingFace 下载 models 到容器内的 /workspace/models 目录。

4.4 查看日志和调试

4.4.1 实时查看日志(类似 tail -f):

sudo docker logs -f musetalk4.4.2 查看容器状态

# 查看运行中的容器

sudo docker ps

# 查看所有容器(包括已停止的)

sudo docker ps -a

# 查看容器资源使用情况

sudo docker stats musetalk4.5 容器内操作

4.5.1 进入容器

sudo docker exec -it musetalk /bin/bash说明-it 参数表示交互式终端/bin/bash 是进入容器后执行的命令。

4.5.2 修复文件名中的 CRLF 问题

如果遇到文件名包含回车符\r)的问题,可以在容器内执行:

# 进入容器

sudo docker exec -it musetalk /bin/bash

# 进入目标目录

cd /workspace

# 一次性修复所有 CRLF 文件名

for f in *$'\r'; do mv "$f" "${f%$'\r'}"; done4.5.3 创建目录和复制文件

在容器内创建目录并复制文件:

4.6 分析GPU占用情况

nvidia-smi -l 1- 感谢你赐予我前进的力量