深入探讨数字人技术:MuseTalk + Realtime API 可能性探讨

随着人工智能(AI)、自然语言处理(NLP)和计算机图形学的迅猛发展,数字人(Digital Humans)已经从科幻概念走向现实,广泛应用于客服、教育、娱乐等多个领域。数字人不仅能够与用户进行自然交互,还能通过高精度的面部动画和声音合成提供逼真的互动体验。本文将深入探讨数字人平台的技术架构与实现,帮助技术爱好者和开发者更好地理解数字人的构建与应用。

一、什么是数字人

数字人是通过高度集成的技术系统生成的虚拟人类形象,它可以通过屏幕与用户进行交互,展示真人般的视觉效果和行为反应。数字人的功能通常包括视觉表现、语音识别与合成、情感识别与表达,以及智能对话等。数字人能够理解和响应用户的语音指令或文字输入,甚至能够根据用户的情绪和需求调整自己的行为方式,提供个性化和人性化的服务。

1.1 数字人的组成部分

视觉表现

动作捕捉与动画:数字人能通过模拟真人的动作数据,保证其动作流畅自然。

语音与语言处理

语音识别(ASR):数字人能够通过语音识别技术,将用户的语音输入转化为文字,并进行理解。

自然语言处理(NLP):理解和生成自然语言,数字人可以根据用户输入的文字或语音提供相应的回应。

语音合成(TTS):将文本内容转化为自然流畅的语音回应,模拟人类的声音,增强互动性。

人工智能与情感计算

对话管理系统:数字人通过智能对话管理系统与用户进行多轮对话,能够在对话过程中进行语境理解和应答,保持对话连贯性。

情感识别与表达:数字人通过分析用户的语气、面部表情等信息,识别出用户的情绪并反馈适当的情感表达,使其交流更加自然和人性化。

互动体验与用户定制

多模态交互:数字人能够支持语音、文字、触摸等多种交互方式,使用户体验更加多样化。

个性化与定制化:数字人的外观、行为和对话风格可以根据用户需求进行定制,适应不同的应用场景。

1.2 数字人的应用领域

数字人的应用场景非常广泛,涵盖了多个行业领域:

客户服务:数字人可用作智能客服,处理用户的咨询、问题解答和技术支持等任务。

教育培训:作为虚拟导师,数字人能够提供个性化教学,并通过语音和表情表达与学生互动。

医疗健康:数字人作为虚拟健康顾问,提供健康建议、心理咨询等服务。

娱乐与社交:数字人在影视、游戏中担任虚拟角色,与用户进行沉浸式互动。

品牌营销:数字人作为品牌代言人或虚拟主播,通过互动吸引用户,增强品牌形象。

二、传统的数字人实现方式

传统的数字人系统通常依赖于多个技术组件的整合,以实现高质量的互动体验。尽管这些技术已广泛应用于许多领域,但在实时交互、口型同步的流畅性以及系统整体的低延迟方面,仍存在一定挑战。以下是传统数字人系统的常见技术栈:

2.1 传统的技术栈

语音识别(ASR):语音识别技术将用户的语音输入转化为文本,帮助数字人理解用户的意图。虽然现有的ASR技术相对成熟,但在噪声环境下的识别精度依然是一个挑战,特别是当用户语速较快或发音不清晰时。

文本到语音合成(TTS):TTS技术将文本转化为语音,能够生成自然流畅的声音,让数字人能够以人类的语气与用户进行语音互动。传统TTS技术虽然可以生成高质量的语音,但它的表达力和情感丰富度仍然有限,尤其在实时对话中,很难精确地根据对话上下文生成个性化语音。

自然语言处理(NLP):NLP用于帮助数字人理解用户的输入,并生成相应的回复。传统的NLP方法通常依赖于规则或模板,或者在深度学习的帮助下实现更复杂的语义分析,尽管如此,很多传统系统仍无法处理极为复杂的、多轮的对话。

面部动画与口型同步:这是传统数字人最具挑战性的部分之一。它通常需要通过视频预处理工具(如DeepFaceLab等)生成面部表情,并与语音同步。面部动画的生成往往依赖于预先录制的视频片段或面部捕捉技术,这些方法通常不够灵活,难以实时应对用户的动态输入。

2.2 传统的局限性

实时性问题:传统方法常常需要进行视频预处理和后处理步骤,无法做到真正的“实时”交互。在生成面部动画时,通常会面临处理延迟,导致用户感知到明显的互动滞后。

口型同步的不自然:传统的口型同步技术通常依赖面部捕捉数据或静态视频的关键帧。这种方式虽然可以提供较为准确的口型动作,但难以做到与实时音频输入的完美配合,常常出现口型与语音不完全匹配的问题。

硬件需求:一些传统方法需要依赖高精度的动作捕捉硬件设备(如专业的摄像头或动作捕捉系统)来捕捉面部表情和动作,这增加了成本和系统复杂度。

三、MuseTalk + OpenAI Realtime API:创新的数字人实现方式

与传统的数字人实现方式不同,我们采用了MuseTalk和OpenAI Realtime API相结合的创新技术架构,从根本上提高了数字人系统的实时性、自然性和交互性。

3.1 什么是MuseTalk

MuseTalk 是一个主要用于 视频生成和口型同步 的技术平台。它利用音频数据生成数字人或虚拟角色的动画视频,确保这些虚拟人物的口型MuseTalk 是一款由腾讯音乐娱乐的 Lyra Lab 开发的先进人工智能工具,专注于实现高质量的实时口型同步,特别用于视频内容的制作。该工具利用 潜空间修复(Latent Space Inpainting)技术,将音频信号转化为与之匹配的口型动画。

3.1.1 主要特点

实时口型同步:MuseTalk 可以将任何音频文件与视频中的人物口型进行精确同步,确保每秒30帧的流畅动画,生成自然且生动的面部表情。

多语言支持:该工具支持多种语言,包括英语、日语和中文,适用于全球用户。

开源免费:MuseTalk 采用 MIT 许可证开源发布,用户可以自由使用和修改,尤其适合开发者和研究人员。

高质量输出:通过 Latent Space Inpainting 技术,MuseTalk 能够生成非常真实的口型同步动画,无需使用之前模型(如 VideoReTalking)所依赖的额外上采样器。

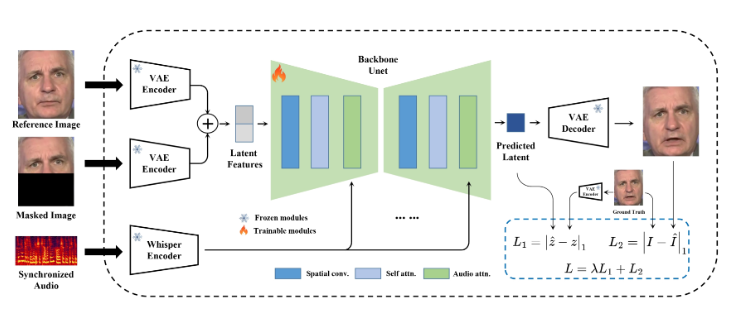

3.1.2 工作原理

MuseTalk 使用了灵感来源于U-Net的神经网络架构,结合了音频和图像特征,并通过交叉注意机制进行融合。该模型利用从音频中提取的嵌入向量来影响视频的视觉输出,特别是口型动作的同步。与基于扩散模型的技术不同,MuseTalk 使用的是一种修复模型,通过修改潜空间来实现口型的精确同步。

3.1.3 应用场景

配音和视频本地化:MuseTalk 可用于为视频进行配音,将原始对话替换为新的语言版本,同时保持人物的面部表情不变,适合多语言内容创作。

AI生成虚拟人物:该工具也被用于生成栩栩如生的虚拟人像,静态图像或视频通过同步音频进行动画化。

照片动画化:虽然 MuseTalk 主要支持视频口型同步,但它可以与其他工具如 MuseV 配合使用,将静态照片转换为“会说话”的照片

3.1.4 限制

计算资源要求高:MuseTalk 在处理高分辨率视频或长音频时需要较强的计算能力,普通设备可能无法顺利运行。

使用门槛:尽管开源,但对于非技术人员来说,MuseTalk 的安装和使用可能有一定的学习曲线。不过,用户可以通过 Google Colab 等平台在云端执行。

偶尔的同步误差:在某些情况下,尤其是在面部动态变化较大的时候,口型与音频的同步可能不完全准确。

3.2 MuseTalk的安装和使用

3.2.1 安装和配置 MuseTalk

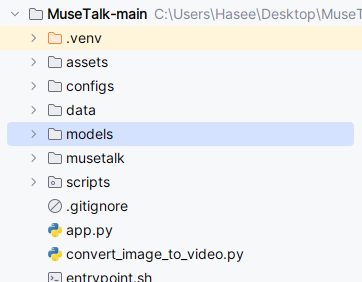

访问 GitHub 页面:首先,前往 MuseTalk 的 GitHub 仓库,下载或克隆项目代码。https://github.com/TMElyralab/MuseTalk

安装依赖:根据项目的 README 文档,安装必要的依赖包和软件环境。

pip install -r requirements.txt

pip install --no-cache-dir -U openmim

mim install mmengine

mim install "mmcv>=2.0.1"

mim install "mmdet>=3.1.0"

mim install "mmpose>=1.1.0" 下载models文件:下载models文件夹,放在项目根目录下。下载地址:https://huggingface.co/hengtuibabai/MuseTalk.models/tree/main

安装ffmpeg:选择合适版本安装,并配置环境变量。下载地址:https://ffmpeg.org/download.html#build-windows

虚拟环境设置ffmpeg:Windows命令行

$env:PATH = 'C:\Software\ffmpeg-7.1-essentials_build\bin;' + $env:PATH3.2.2 运行 MuseTalk

配置好环境后,我们可以使用项目提供的命令运行该项目。这里提供了两种方式运行项目:常规推理 和 实时推理。

1. 常规推理 (python -m scripts.inference)

适用场景:适用于批量处理(例如生成一系列视频或处理较大的数据集),或者在推理过程中需要更多的控制参数。

输入:

video_path可以是视频文件、图像文件或图像目录,同时也支持音频路径(audio_path),用于视频生成和口型同步。输出:生成视频或图像,通常是按帧生成,可以通过设置不同的

bbox_shift来调整结果。推理步骤:

进行模型推理并生成视频或图像。

适用于需要预处理阶段的复杂任务,例如人脸检测、解析等。

控制参数:

可以通过

--bbox_shift等参数来微调结果,调整张口度或蒙版区域,具体参数需要根据默认配置值来调节。

适用设备:该方法通常适用于处理能力较强的设备,推理速度较慢,尤其是在较大视频数据的情况下。

适用情况:如果你需要精确的控制推理结果(如张口度、口型同步效果),并且能够接受稍慢的生成速度。

示例命令:

python -m scripts.inference --inference_config configs/inference/test.yaml --bbox_shift -72. 实时推理 (python -m scripts.realtime_inference)

适用场景:适用于实时生成视频或音频口型同步的情况,尤其是在需要快速反馈和实时推理的应用中。

输入:

preparation(准备阶段)标志设置为True,并且avatar、audio_clips等配置文件提供实时推理所需的数据。输出:实时推理的结果通过子线程传输,用户可以实时查看生成的视频或音频口型同步效果。

推理步骤:

该方法专为实时处理设计,因此推理过程只涉及

UNet和VAE解码器,从而加快生成过程。实时推理将通过流式传输生成的图像或视频,避免了传统的批量处理步骤。

控制参数:

可以通过

--skip_save_images参数跳过保存图像的步骤,进一步加速推理过程。

适用设备:该方法适用于高性能的设备(如 NVIDIA Tesla V30 或其他具备强大计算能力的显卡),以实现高帧率和快速响应。

适用情况:如果你需要快速生成视频并且能够接受实时推理的流式输出,或者在需要即时交互的应用中使用。

示例命令:

python -m scripts.realtime_inference --inference_config configs/inference/realtime.yaml --batch_size 4 --skip_save_images3. 对比

常规推理:当你需要处理一批数据,或者需要对每个视频的结果进行微调和精细控制时使用。

实时推理:当你需要实时生成视频并进行交互时使用,特别适用于直播或实时语音/视频生成的场景。

在本项目中我们当然将使用实时推理。

3.3 什么是OpenAI Realtime API

OpenAI Realtime API 是 OpenAI 提供的一个高效的实时 API,旨在通过减少延迟,提供即时反馈,特别适用于需要低延迟交互的应用场景,如聊天机器人、实时语音生成、实时对话系统等。与传统的批量处理 API 相比,Realtime API 能够在处理请求时保持低延迟,从而更好地支持实时应用和交互式场景。

OpenAI Realtime API 的主要特性:

低延迟响应:

Realtime API 设计的核心目标是为实时交互提供低延迟服务。这对于需要快速反馈的应用,如聊天机器人、语音识别、视频生成和实时对话等,尤其重要。

该 API 可确保请求和响应之间的延迟最小化,通常在几百毫秒内,取决于请求的复杂度和网络状况。

流式传输(Streaming):

通过流式传输,OpenAI Realtime API 能够逐步返回生成的内容,这意味着你可以在请求处理的同时开始接收结果,而不必等待整个响应完成。

这种流式处理适用于生成长文本或连续音频/视频内容的场景,如对话生成、文本实时翻译、语音实时生成等。

实时语音生成:

OpenAI Realtime API 还可以与语音合成技术(如 TTS)结合,实时生成音频数据。这使得它成为开发虚拟助手、AI 客户支持、互动游戏中的数字人等应用的理想选择。

实时语音生成能够保证在短时间内接收到用户输入并实时生成语音反馈,提供更自然的互动体验。

支持多模态交互:

与其他 OpenAI 的多模态模型一样,Realtime API 也支持结合文本、图像和音频进行交互。例如,你可以同时传递文本和图像输入,获得图文结合的输出。

结合多模态的处理,可以让应用不仅仅局限于文本,还能扩展到图像和音频的实时处理和生成。

高并发:

OpenAI Realtime API 能够处理大量并发请求,非常适合需要支持多用户的应用,如在线客服、直播互动、实时会议等。

该 API 支持高并发场景下的请求分发和快速响应,因此适用于大规模在线应用。

四、采用MuseTalk + OpenAI Realtime API的优势

4.1 更高的实时性与低延迟

传统方式:传统的数字人系统通常在生成音频和视频时存在较高的延迟,特别是在处理动态交互时。通常,视频预处理和口型同步的处理时间较长,导致用户感知到互动滞后。系统在生成面部动画时,通常依赖事先录制或生成的关键帧,而无法做到完全实时响应。

我们的方式:采用 MuseTalk 和 OpenAI Realtime API 的组合,能够实时处理音频输入并同步生成高质量的口型动画。通过音频驱动面部动画,能够以几乎零延迟的方式进行互动,确保数字人的口型与语音完全同步。用户几乎感受不到延迟,极大提升了交互体验。

4.2 流畅的口型同步与自然表达

传统方式:传统口型同步技术常依赖视频预处理工具和手动制作的表情库,生成的口型动画通常较为生硬或不自然。由于这些工具多依赖静态关键帧或已录制的面部表情,处理动态变化时会存在卡顿或不一致的情况,尤其在高互动频率下,效果更加显著。

我们的方式:MuseTalk 利用潜空间修复技术(Latent Space Inpainting)来生成精确的口型同步动画,消除了传统方法中卡顿和不流畅的口型同步问题。MuseTalk 还具有对音频信号的实时响应能力,能够根据音频数据即时生成面部表情,确保数字人表现自然且富有表现力。

4.3 跨模态的互动能力

传统方式:传统数字人系统通常专注于语音与视频或图像的单一模态交互,功能相对局限。如果想要扩展到其他模态(如图像生成、视频生成等),需要额外集成其他技术,增加了系统的复杂度和开发难度。

我们的方式:结合 OpenAI Realtime API 和 MuseTalk,我们能够实现跨模态的实时交互。例如,可以根据用户输入实时生成文本、语音、图像和视频内容。OpenAI 的强大自然语言处理能力帮助数字人理解复杂的对话内容,同时支持图像和视频生成,让数字人的表现更加多样化。

4.4 成本效益与硬件需求

传统方式:很多传统数字人系统依赖高精度的动作捕捉硬件,如专业的摄像头或动作捕捉系统。这些设备昂贵且需要复杂的维护,增加了整体系统的部署成本和操作难度。

我们的方式:我们采用 MuseTalk 和 OpenAI Realtime API 结合的方式,极大降低了对高端硬件的依赖。只需要基本的音频输入和基础的面部动画生成技术,即可实现高质量的实时口型同步和语音输出。这样不仅减少了硬件成本,还简化了系统的部署和维护过程,使得我们的方案更加经济高效。

4.5 高精度的语音与语境理解

传统方式:传统的语音合成与自然语言处理技术虽然可以生成可理解的语音和响应,但通常缺乏足够的语境理解能力。对于长时间的对话,传统方法可能会发生语义混乱或无法有效管理多轮对话的上下文。

我们的方式:OpenAI Realtime API 基于先进的预训练模型,能够理解复杂的语境和多轮对话。其流式处理技术能够持续追踪对话中的语境变化,并生成连贯、自然的对话内容。这种高精度的语义理解能力,使得数字人能够像人类一样自然地应对用户的各种问题和需求。

4.6 更强的适应性与灵活性

传统方式:传统数字人系统通常需要预先录制大量的音频和视频内容,包括语音库、面部表情库等。这些内容生成和更新的过程比较繁琐,难以应对动态变化的需求。特别是对于多语言或多场景的适配,需要大量的前期工作。

我们的方式:OpenAI Realtime API 的灵活性使得我们可以快速适配不同的语言、情感表达和场景需求。它支持流式生成,能够根据不同的上下文动态调整响应,而 MuseTalk 的实时口型同步也能够轻松适应这种动态变化,使得数字人在多个不同场景和应用下都能够保持一致的高表现。

4.7 支持大规模的实时互动场景

传统方式:传统数字人往往适用于单一、低频的互动场景,例如静态教程或预录制的虚拟助手。而在面对大规模的用户交互时,传统系统的实时处理能力和响应效率可能会受限。

我们的方式:借助 OpenAI Realtime API 的低延迟、高效响应能力,我们的系统可以处理大规模的实时互动,尤其适用于在线教育、虚拟客服、智能助手等需要高频交互的场景。无论是单一用户还是多个用户同时交互,系统都能高效稳定地处理并提供即时响应。

4.8 可扩展性与持续优化

传统方式:传统数字人技术的优化通常是线性的,增加新功能往往需要大量的开发和测试工作。此外,系统在面对不断变化的用户需求时,往往需要重新构建或大规模调整原有架构。

我们的方式:MuseTalk 和 OpenAI Realtime API 为我们提供了更强的可扩展性。由于这两项技术都具有很高的灵活性,我们可以迅速加入新的功能(如语音情感分析、个性化对话管理等),并进行持续优化。随着AI技术的发展,我们的系统能够快速吸纳新的创新成果,保持竞争力。

那么如何构建,并结合这两个技术,实现实时数字人对话呢?将在下一篇文章中给出答案!

- 感谢你赐予我前进的力量